Ảo giác trong LLM

Các mô hình ngôn ngữ lớn (LLM) là các hệ thống trí tuệ nhân tạo có khả năng phân tích và tạo văn bản giống con người. Nhưng họ có một vấn đề – LLM ảo giác, tức là bịa chuyện. Ảo giác LLM đã khiến các nhà nghiên cứu lo lắng về sự tiến bộ trong lĩnh vực này bởi vì nếu các nhà nghiên cứu không thể kiểm soát kết quả của các mô hình, thì họ không thể xây dựng các hệ thống quan trọng để phục vụ nhân loại.

“Các mô hình ngôn ngữ lớn không có ý tưởng về thực tế cơ bản mà ngôn ngữ mô tả. Những hệ thống đó tạo ra văn bản nghe có vẻ ổn, đúng ngữ pháp và ngữ nghĩa, nhưng chúng không thực sự có mục tiêu nào khác ngoài việc chỉ đáp ứng tính nhất quán thống kê với lời nhắc”. Yann LeCun

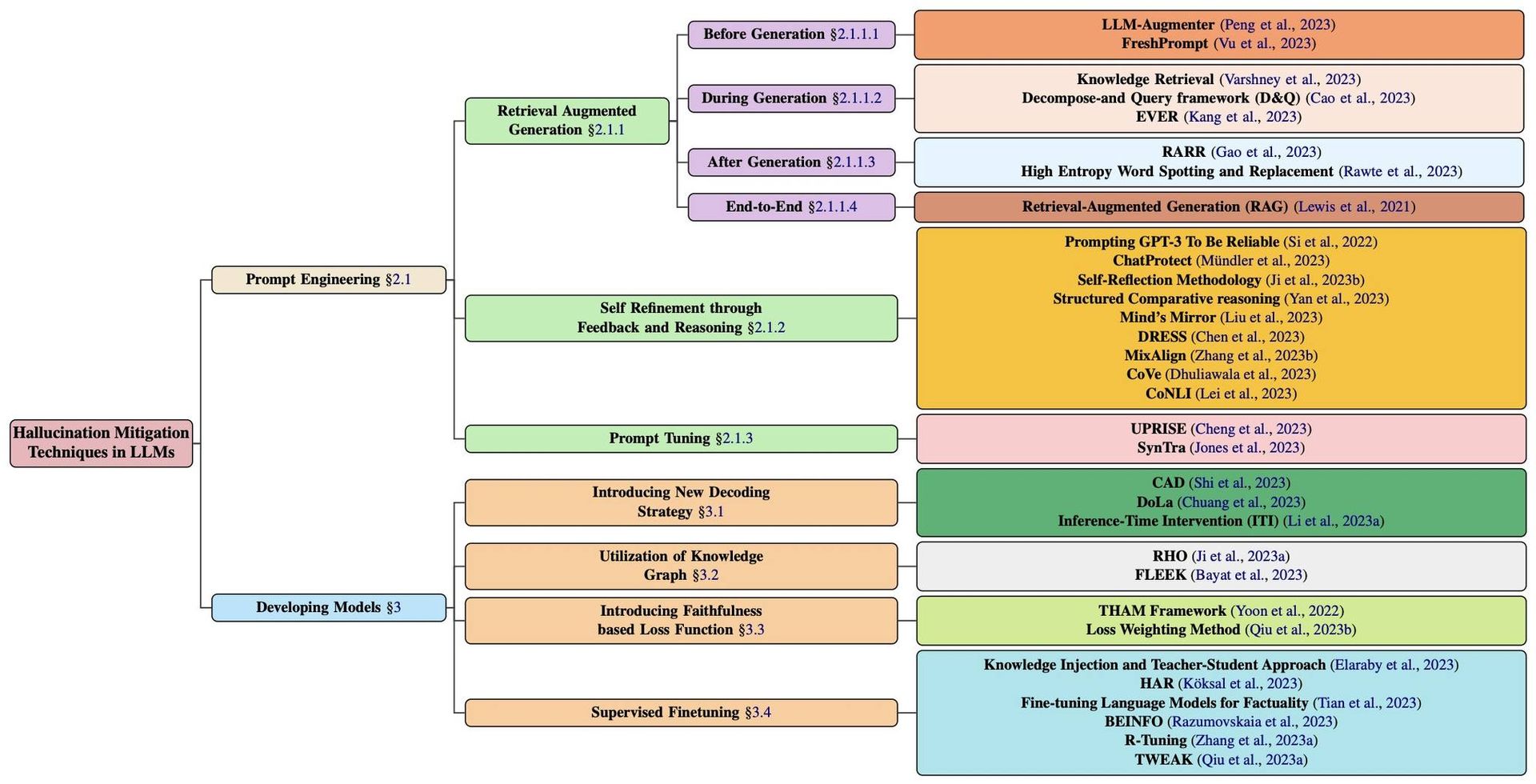

Bài báo này tuy chưa thể gọi đây là bài báo tốt (vì phương pháp luận không có gì đáng kể), nhưng hữu ích cho những ai quan tâm đến vấn đề này vì có điểm qua tới 32 kĩ thuật khác nhau chia thành các nhóm phương pháp.

Nguồn: https://arxiv.org/abs/2401.01313